O uso de Inteligência Artificial em processos de desenvolvimento de software já faz parte da rotina de 51% dos profissionais, segundo os estudos do Stack Overflow Survey de 2025. A pesquisa recebeu mais de 49 mil respostas, enviadas por usuários de 177 países.

O próprio Stack Overflow, plataforma onde desenvolvedores e profissionais de tecnologia tiram dúvidas entre si sobre programação, sentiu os efeitos dessa mudança. Em dezembro de 2024, o site recebeu mais de 18 mil perguntas, enquanto o número em 2025 foi de 3.862 para o mesmo período. Uma redução de 78,5%.

Não é difícil chegar aos motivos: se a IA entrega a resposta em segundos, não faz sentido para esses desenvolvedores esperarem semanas por uma resposta de um colega mais experiente.

A criação do GenAI Security Project

A maioria dos desenvolvedores que responderam à pesquisa do Stack Overflow (52%) não utiliza agentes ou prefere utilizar ferramentas mais simples. E uma parcela significativa (38%) também não pretende adotar um agente de IA.

E isso é um problema. Usar um agente de IA customizado, com guardrails de segurança, e simplesmente copiar código gerado por um LLM sem contextos e controles é a diferença que pode abrir, ou evitar, vetores de entrada e ataque para um incidente de segurança grave.

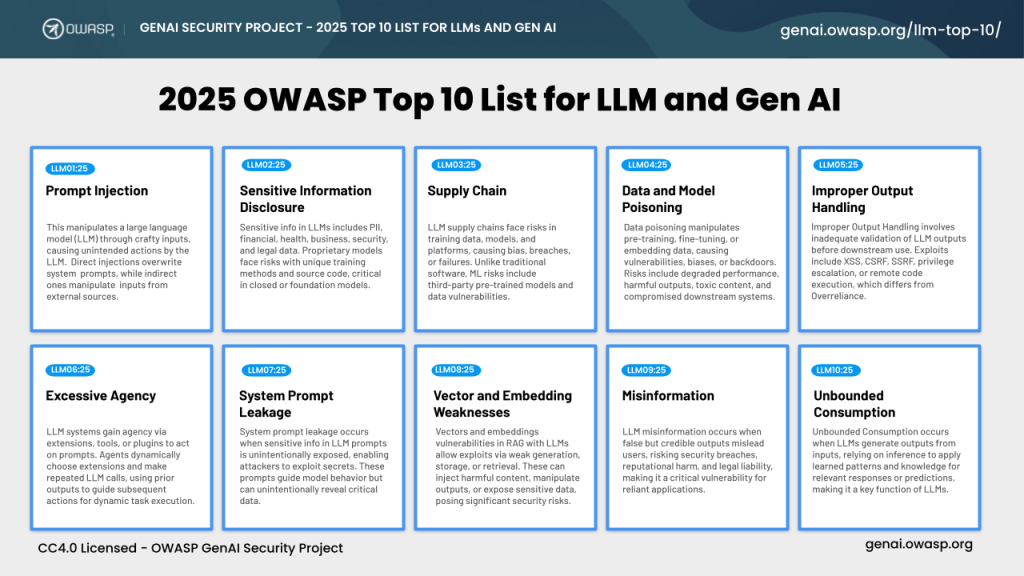

A importância do tema levou a OWASP a criar, em 2023, um projeto focado em segurança de aplicações de IA generativa, com guias, checklists e referências open source.

Esse projeto surgiu a partir do OWASP Top 10 for LLM Applications, um framework dedicado exclusivamente aos riscos de segurança em sistemas que utilizam (LLMs) e IA generativa.

Assim como o tradicional OWASP Top 10, o OWASP Top 10 for LLM Applications funciona como um guia para empresas que estão “IA-first”, ajudando a transformar “experimentos com LLMs” em arquiteturas seguras, com políticas, controles técnicos e critérios de risco claros.

Como hackear uma IA: uma demonstração

Durante o RedTalks que tratou sobre riscos e desafios da IA generativa em AppSec, Júlio Raveli, consultor de DevSecOps na Redbelt Security, utilizou uma plataforma gamificada de segurança para demonstrar, na prática, como o Prompt Injection (LLM01:2025) funciona. O desafio foi extrair uma senha protegida por um chatbot com múltiplos níveis de segurança.

Nos primeiros níveis, sem guardrails implementados, bastou perguntar diretamente ao LLM “qual era a senha”. Nos níveis mais avançados, com proteções ativas, a estratégia mudou.

O exercício apresentado deixou claro que, sem governança e controles adequados, a IA tende a seguir instruções de forma acrítica, mesmo quando isso significa violar regras de segurança.

Assista ao RedTalks completo com a demonstração aqui:

Agentes de IA com governança adequada

A resposta para usar IA com segurança não está em evitá-la, mas em implementá-la corretamente. Como destacamos, a maioria dos desenvolvedores limita o uso de IA a ferramentas básicas de copilot e autocompletar.

O ponto fundamental dessa prática está na governança. Um agente de IA é como um “funcionário virtual especializado”, com regras claras do que pode e não pode fazer, enquanto usar IA generativa diretamente é como contratar alguém sem treinamento, supervisão ou políticas a seguir.

Implemente IA na sua empresa com segurança

A adoção de IA generativa é inevitável, mas pode ser feita de forma segura. Nós, da Redbelt Security, oferecemos serviços especializados de DevSecOps que incluem assessment de maturidade, implementação de ferramentas de análise automatizada, criação de agentes de IA com governança e treinamento de equipes, sempre baseados em frameworks de mercado com as melhores práticas.

Fale com nossos especialistas e descubra como transformar segurança na produtividade em vantagem competitiva.